【miibo活用術】会話のシミュレーションで会話型AI開発を効率化する方法

複数質問の自動実行で開発サイクルを加速し、応答品質を高める実践ガイド

会話型AI開発では、プロンプトの微細な変更や言語モデルの切り替えが応答品質に大きな影響を与えます。開発者は変更の都度、AIの応答を効率的に確認・検証する手段が不可欠です。本稿では、miiboが提供する「会話のシミュレーション」機能について、その活用法と効果を解説します。

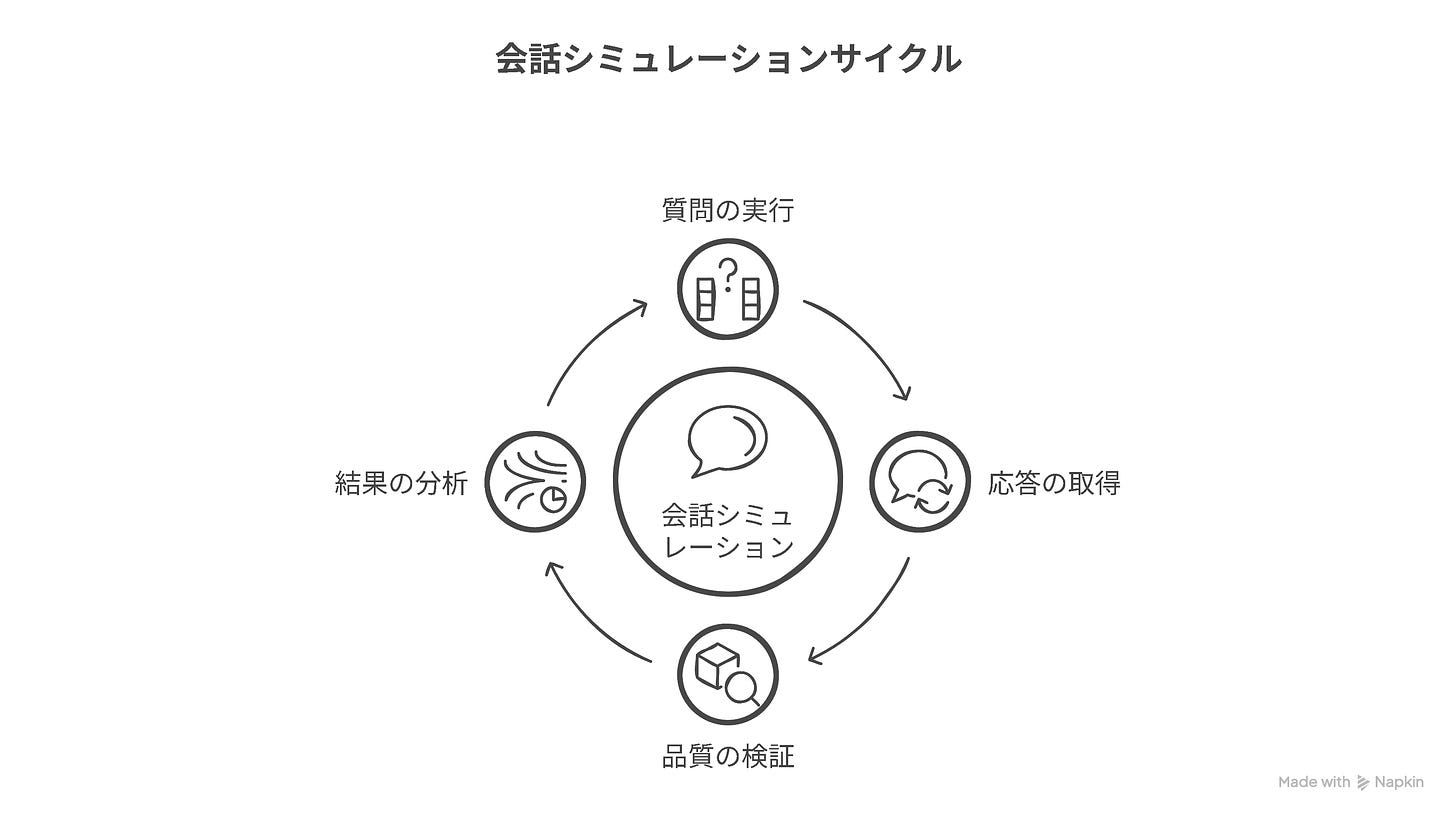

会話のシミュレーションは、AI開発プロセスを劇的に効率化する強力なツールです。複数の質問を一括設定して自動的に会話を実行し、応答を一覧で取得できるため、手動テストの手間を大幅に削減できます。プロンプトや言語モデルの変更後に品質検証を行う際に特に効果を発揮し、一貫性のあるテスト環境を提供します。簡単な操作で会話の自動実行と詳細なログ分析が可能なため、開発サイクルをスピードアップさせるとともに、品質向上に直結します。

会話のシミュレーションの概要

会話のシミュレーションは、複数の質問を一括でAIに投げかけ、自動的に応答を記録する機能です。従来の手動テストでは、開発者が一つずつ質問を入力し応答を確認する必要がありましたが、この機能によりプロセス全体が自動化されます。質問リストを一度設定するだけで、システムが順次AIとの会話を実行するため、テスト効率が飛躍的に向上します。

この機能は、AIとの会話を自動的に実行し、人間の介入なしに一連の対話を完了させることで、開発効率を向上させます。シミュレーション実行中は、システムが指定された質問を順次AIに投げかけ、その応答を即時に記録します。また、クイックリプライからの自動発話機能を活用すれば、ユーザーとAIの自然な会話の流れも再現可能です。これにより、実際のユーザー環境に近い形でのテストが実現し、より実践的な検証ができます。

会話のシミュレーションのユースケース

プロンプト変更後の効果検証は、会話のシミュレーションの主要なユースケースです。プロンプトの微調整を行った際、同一の質問セットに対する応答の変化を客観的に比較できるため、変更の効果を具体的に確認できます。プロンプトのバージョン間で応答品質の比較を行い、最適な表現や指示方法を見つけ出せるため、プロンプトエンジニアリングの精度向上に直結します。

言語モデルの切り替え時には、同一の質問セットで性能比較をすることで、最適なモデル選択が可能になります。GPTからClaudeへの切り替え、GPT-4oからGPT-4.1へのアップグレードなど、モデル変更の影響を同一条件下で評価できるため、コストと性能のバランスを客観的に判断できます。モデル別の応答特性や処理速度、精度の違いを数値化して比較することで、プロジェクトに最適なモデルを選定する根拠を得られます。

複数の質問パターンでの検証は、AIの応答の一貫性と柔軟性を確認するのに役立ちます。標準的な質問から難解な質問、エッジケースまで様々なパターンを用意することで、AIの対応範囲と限界を把握できます。同じ内容を異なる表現で質問するケースや、意図的に曖昧な表現を含める質問など、多角的な検証を自動化することで、実環境での頑健性を確保できます。

会話のシミュレーションの利用方法

シミュレーション設定は「会話の設定」メニューからアクセスし、必要な質問を入力します。左側メニューの「会話の設定」を選択し、その中から「会話のシミュレーション」を選ぶと設定画面が表示されます。質問入力欄に、AIに応答させたい質問を1つずつ入力し、「質問を追加」ボタンをクリックすることで、複数の質問を登録できます。登録した質問は編集や削除も可能なため、テストケースを柔軟に調整できます。

ユーザーIDと追加やり取り回数の設定により、テスト条件をカスタマイズできます。「初期ユーザーID」欄では、シミュレーションでのユーザー識別子を指定でき、後から会話ログを確認する際にシミュレーションデータであることをすぐに識別できます。「追加のやり取り回数」は0〜5回の範囲で設定可能で、1以上を指定するとAIの応答に表示されるクイックリプライを自動的に選択して会話を継続します。この機能により、初期質問だけでなく、続く対話の流れも検証できます。

会話の文脈維持オプションを活用することで、連続した対話のシミュレーションが可能です。「会話の文脈を維持」にチェックを入れると、各質問間で会話履歴が引き継がれるため、前の質問の内容を踏まえた応答がテストできます。チェックを外した場合は、それぞれの質問が独立した会話として扱われ、前後の文脈に影響されない一問一答形式のテストになります。この設定により、文脈依存の応答特性や、独立した質問への対応力など、異なる状況での性能を評価できます。

シミュレーション後は、実行結果を確認し、会話ログ画面で詳細分析を行えます。「シミュレーション開始」ボタンをクリックすると自動的に会話が実行され、完了後に各質問と応答のペアが一覧表示されます。各応答には「ログを見る」リンクが表示され、これをクリックすると「会話のログ」画面に移動して、その会話の詳細情報を確認できます。ログ画面では使用された知識やプロンプト、検索クエリなどの詳細情報にアクセスでき、応答生成の過程を詳しく分析できます。

会話のシミュレーションの活用テクニック

効果的なシミュレーションには、エッジケースを含む多様な質問セットを準備することが重要です。一般的な質問だけでなく、専門的な内容や曖昧な表現、誤字脱字を含む質問など、実際のユーザーから寄せられる可能性のある様々なケースを想定しましょう。定期的に使用する標準テストセットを用意しておくと、アップデートの前後で同一条件の比較ができるため、変更の効果を正確に測定できます。また、実際のユーザーから寄せられた質問を定期的にテストセットに追加することで、現実の利用状況に即した検証が可能になります。

会話のシミュレーションは開発サイクルに組み込むことで、継続的な品質向上が実現します。プロンプトの変更やモデルの切り替えなど、重要な更新を行う前後に必ずシミュレーションを実行する習慣を身につけることで、品質の後退を防ぎます。定期的なシミュレーション実行をスケジュール化し、結果の推移を記録しておくと、長期的な品質変化の傾向も把握できます。また、複数の開発者でプロンプト改善に取り組む場合、シミュレーション結果を共有することで、客観的な評価基準を元にした議論が可能になります。

ログデータを活用した分析により、AIの応答パターンや改善点を客観的に把握できます。シミュレーション後の会話ログには、使用された知識ソースや検索クエリ、プロンプトなどの詳細情報が記録されています。これらのデータを分析することで、応答品質に影響している要因を特定できます。特に改善が必要な質問パターンや、特定の知識ソースへの依存度、クエリ生成の精度など、多角的な視点での評価が可能です。定量的な指標(応答時間、使用知識数など)と定性的な評価(応答の適切さ、トーンの一貫性など)を組み合わせることで、より包括的なAI性能の把握と改善につなげられます。

まとめ

会話のシミュレーションは、miiboでのAI開発を効率化し、品質を一貫して向上させるための強力なツールです。複数の質問を自動的に実行して結果を一覧で取得できるこの機能は、プロンプトや言語モデルの変更効果を客観的に検証する際に特に威力を発揮します。シンプルな設定と直感的な操作性により、開発者の労力を大幅に削減しながら、より精度の高いテストが可能になります。会話のシミュレーションをAI開発プロセスに組み込むことで、ユーザー体験の継続的な向上を実現し、より実用的で信頼性の高い会話型AIの構築を加速させましょう。